WeClone数字分身:另一个“你”

我们可以通过大模型的强大能力,训练出一个高度相似于你自己的“数字分身”。这个过程不仅仅是简单地复制语言内容,而是深入学习你的聊天风格、常用的口头禅,以及那些独具特色的表达方式和思维逻辑。通过大量对话数据的输入与反复训练,AI 能逐渐掌握你的语言习惯和交流节奏,最终在数字世界中“复刻”出一个非常接近你风格的 AI 形象。

1

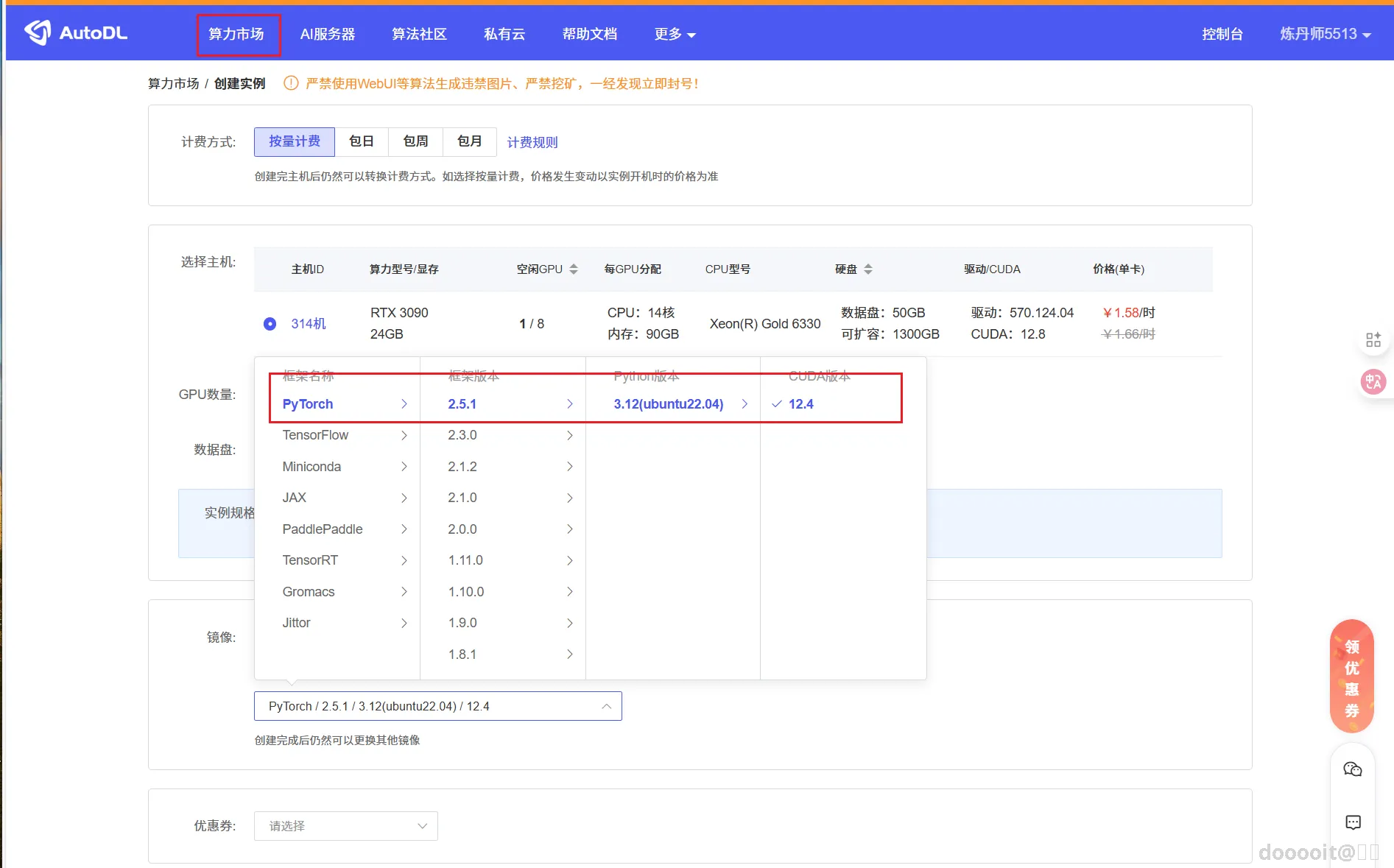

购买AutoDL

2

安装虚拟环境

3

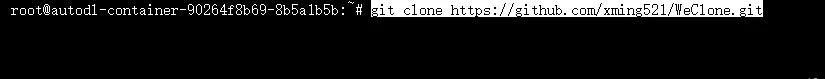

拉取项目

4

创建虚拟环境

5

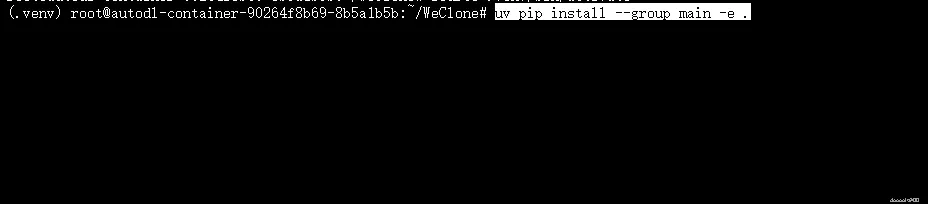

安装相关依赖

6

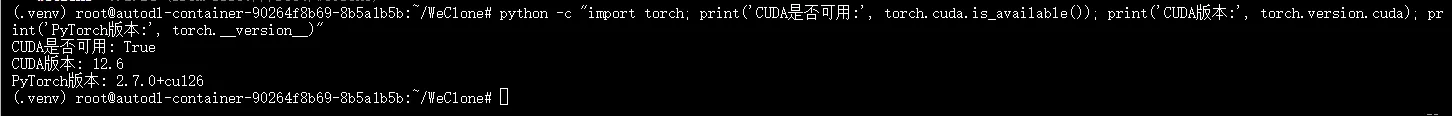

检验环境

7

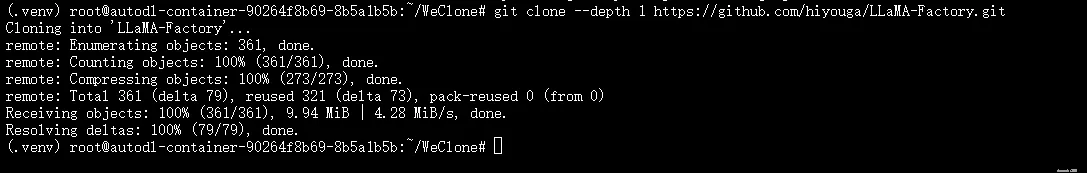

安装LLaMA-Factory(用于训练模型)

8

下载千问模型

9

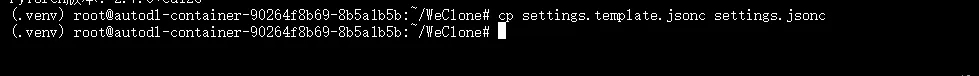

配置WeClone设置

10

生成训练数据集

11

训练模型

12

本地访问

0

0 0

0 0

0猜你喜欢

评论/提问(已发布 0 条)

0

0

微信

微信  qq空间

qq空间  微博

微博  贴吧

贴吧  复制链接

复制链接  分享

分享